IA: Sabiduría omnisciente o basura digital? (Parte 3)

IA: Sabiduría omnisciente o basura digital? (Parte 3)

Campañas Maliciosas y Grupos Organizados: Manipulación de Motores de IA

Las respuestas inconsistentes y las toneladas de basura digital obtenidas por IA no son sólo causa de cuestiones de diseño de los LLM ni obedecen exclusivamente a descuidos en la calidad de la información que los alimenta. Si ya venías leyendo la Parte 1 y la Parte 2 de este informe, estarás por lo menos sospechando que hay tambien mucho interés de diversos sectores políticos, empresariales y delictivos en manipular de una u otra manera el comportamiento de las IA.

LLM Grooming y Contaminación Algorítmica

Una de las estrategias más sofisticadas de manipulación es el LLM grooming, una táctica atribuida por Occidente principalmente a actores estatales como Rusia y China, que consiste en inundar la web con grandes volúmenes de contenido sesgado, diseñado específicamente para ser capturado por los rastreadores de datos que alimentan los modelos de lenguaje (LLM). Del lado Oriental del mundo, las responsabilidades se adjudican a USA y a los grandes jugadores del mercado capitalista occidental. Lo cierto es que nadie esta excento de culpas y, casi en igual medida, todos meten los dedos para manejar los hilos de la IA en favor propio. Y el objetivo es el mismo para todos los bandos: que los sistemas de IA integren sus narrativas manipuladas en las respuestas, convirtiéndose en vectores involuntarios de propaganda.

Caso Portal Kombat

En 2024, la agencia francesa VIGI-NUM/SGDSN documentó la operación Portal Kombat, una red de al menos 193 portales web dedicados a replicar masivamente publicaciones de medios rusos y figuras pro-Kremlin. Estos sitios optimizan su contenido para motores de búsqueda y agregadores de noticias, asegurando su indexación y posterior integración en los conjuntos de datos de entrenamiento de los LLM.

Impacto en la Opinión Pública y los Modelos de IA

El LLM grooming desplaza la base cognitiva de los sistemas automatizados, sesgando sus respuestas sobre temas sensibles como la guerra en Ucrania, la OTAN o procesos electorales. Así, la manipulación ya no se dirige solo a los usuarios humanos, sino a los propios algoritmos que median la información global.

Operaciones de Desinformación en Redes Sociales

El informe Virtual Manipulation Brief 2025 del Centro de Excelencia de Comunicaciones Estratégicas de la OTAN identificó más de 1.900 campañas pro-Kremlin altamente coordinadas, muchas de ellas apoyadas en bots, cuentas falsas y contenido generado automáticamente por IA. Estas campañas operan en plataformas como X (Twitter), Telegram, YouTube y TikTok, explotando eventos políticos clave para amplificar narrativas de propaganda.

Técnicas Utilizadas

- Reposteo masivo y bots automatizados: Crean la ilusión de consenso y viralidad.

- Personas ficticias generadas por IA: Fotos y perfiles creados con DALL·E o GANs para dar credibilidad a narrativas falsas.

- Integración de IA conversacional: Bots como Grok en X permiten interactuar directamente con sistemas de IA, facilitando la manipulación emocional y la polarización.

Plataformas Más Vulnerables

- X (Twitter): Difusión masiva con baja interacción real.

- Telegram y YouTube: Mayor profundidad y engagement, ideales para campañas emocionales.

- TikTok: Clave para influir en públicos jóvenes con videos manipulados o fabricados.

Casos Políticos y Propaganda

En Estados Unidos, la administración Trump fue señalada por utilizar imágenes y videos generados por IA en campañas oficiales y redes sociales, incluyendo deepfakes de figuras públicas y materiales diseñados para polarizar audiencias. En el ámbito internacional, tanto Rusia como China han sido identificados como principales impulsores de campañas de desinformación basadas en AI slop, utilizando técnicas de spamouflage y fake influencers para amplificar mensajes divisivos.

Impacto en Motores de Búsqueda, Redes Sociales y Modelos de Lenguaje

Motores de Búsqueda y Respuestas Automatizadas

La integración de modelos de IA como Gemini en los resultados de búsqueda de Google marcó un punto de inflexión en la visibilidad y el impacto del AI slop. A partir de mayo de 2024, la función AI Overview comenzó a generar respuestas automáticas, desplazando los enlaces tradicionales y aumentando la exposición de contenido sintético.

Consecuencias

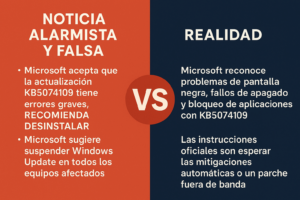

- Saturación de resultados: Los buscadores muestran cada vez más respuestas generadas por IA, muchas veces basadas en materiales de baja calidad o directamente falsos.

- Desinformación y errores: Ejemplos como la sugerencia de «añadir pegamento no tóxico» para hacer que el queso se pegue mejor a la pizza ilustran los riesgos de confiar en respuestas automatizadas sin verificación humana.

- Crisis de confianza: La proliferación de AI slop en buscadores erosiona la credibilidad de las plataformas y dificulta encontrar información útil y verificada.

Redes Sociales y Plataformas de Video

Plataformas como TikTok, YouTube, Instagram, Facebook y X han sido especialmente vulnerables a la invasión de AI slop. El contenido viral generado por IA, desde videos absurdos hasta memes y audios clonados, domina los feeds y desplaza a los creadores humanos.

Ejemplos y Tendencias

- Videos virales de AI slop: Clips de animales humanizados, personajes deformados y narrativas surrealistas que captan la atención en segundos.

- Música generada por IA: Plataformas como Spotify y Deezer reportan millones de pistas automatizadas, muchas de ellas utilizadas para inflar estadísticas y obtener regalías fraudulentas.

- Fake news y desinformación: Noticias falsas, entrevistas inventadas y audios clonados de celebridades se difunden masivamente, dificultando la verificación y el control.

Respuestas de las Plataformas

- TikTok: Implementación de etiquetas «Created with AI», controles para ajustar la cantidad de contenido generado por IA en el feed y marcas de agua invisibles para detectar audio y video sintético.

- Meta (Facebook, Instagram): Uso de protocolos como C2PA y marcas de agua digitales para identificar y etiquetar contenido generado por IA.

- Google: Herramientas como SynthID para incrustar marcas de agua en imágenes y videos generados por IA, facilitando su detección y etiquetado.

Modelos de Lenguaje y Degradación de Datos

La saturación de AI slop no solo afecta a los usuarios, sino también a los propios modelos de lenguaje, que dependen de grandes volúmenes de datos para su entrenamiento. Cuando estos datos están contaminados por contenido sintético, los modelos pueden desarrollar alucinaciones, sesgos y degradación en la calidad de sus respuestas.

Riesgos Identificados

- Refuerzo de sesgos y estereotipos: Los modelos replican y amplifican los prejuicios presentes en los datos de entrenamiento, afectando la representación de grupos sociales y la equidad en las respuestas.

- Alucinaciones y errores: Generación de información falsa o inexacta, presentada con un tono de autoridad que puede engañar a los usuarios.

- Retroalimentación negativa: Los modelos de IA se entrenan con salidas de IA, generando un círculo vicioso de degradación y pérdida de valor informativo.

Estudios y Análisis Técnicos

Investigaciones de la Universidad de Buenos Aires y Fundar han demostrado que los LLM tienden a alinearse con segmentos específicos de la población, reproduciendo sesgos de género, ideología y nivel educativo presentes en los datos de entrenamiento. Además, el Sesgo Lingüístico Digital (SLD) afecta especialmente a los modelos en español, que suelen estar entrenados mayoritariamente con datos en inglés y no reflejan la diversidad dialectal y cultural del mundo hispanohablante.

Y entonces que hacemos?

A continuación vamos a revolver un poco entre las medidas que estados y organizaciones han implementado o estan estudiando implementar. Nada demasiado prometedor puesto que en la mayoría de los casos (tal como ocurre con la contaminación y el calentamiento global), pretenden ofrecernos soluciones los mismísimos actores que causaron el problema.